TG客服:@SSjiejie — 官方频道:@SSwangluo

三生网络 © 2009-2023 超15年出海经验,跨境项目专家

企业运营多年会积累大量的数据,这些数据会存储在各种应用系统和技术平台中,例如关系型数据库,Hadoop分布式文件系统和文件系统,也会以各种各样的格式存储,例如服务器日志,JSON,Parquet,纯文本,数据库导出文件等,如何经济的统一管理这些数据,并且在数据加工和分析需要的时候能够快速访问和查询这些数据,无需频繁移动和多份复制,是企业面临的挑战。

业界十年前提出了数据湖的概念,发展到今天,公有云服务商更多的把低成本,高可用性,安全的对象存储作为推荐的数据湖解决方案,同时为了让用户有效使用这些数据创造价值,湖(数据湖)仓(数据仓库)一体解决方案也在不断发展,但现在其他方案存在诸多限制,例如很多的湖仓一体引擎都是基于Hadoop或Spark技术体系之上,因此:

·技术组件众多,部署复杂,手工维护工作量较大,

·不同查询场景下数据往往要多份复制,数据膨胀比较快,

·支持的SQL有限,提供的分析功能过于简单,

·安全管控能力较弱

·还需要使用其他多种工具再加工等等

这些对于技术人员相对较少的企业级客户来说,都会带来巨大的挑战,也不利于数据的快速应用。

Oracle多年来一直提供基于Oracle SQL的融合的企业级全数据管理解决方案,这些技术在公有云中也不断发展完善,逐渐形成了基于SQL的湖仓一体的数据湖仓(Lake House=Data Lake+DataWarehouse)解决方案,帮助企业实现低成本统一存储各种类型数据,并且能够利用Oracle SQL和高效稳定安全的企业级数据仓库引擎来灵活和深度使用这些数据,从而帮助企业创造价值,提升数字化转型的敏捷性。

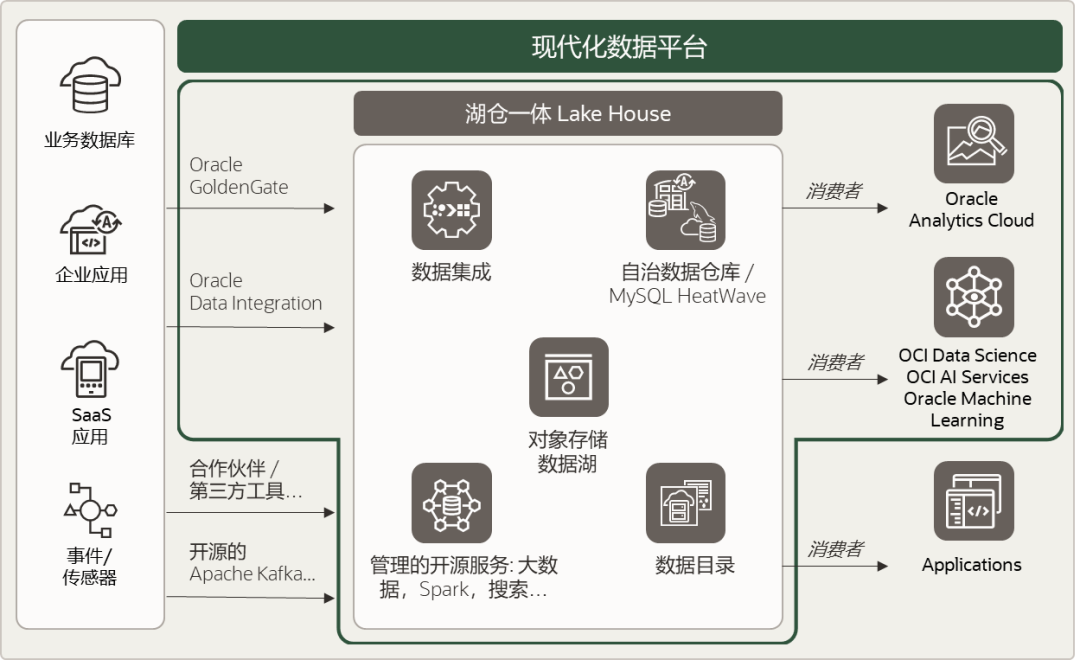

Oracle湖仓一体(LakeHouse)模式结合了来自数据仓库和数据湖的最佳元素。它提供了多个Oracle云服务协同工作的现代化数据平台,可轻松融合访问数据,移动数据、统一治理,并提供根据用户的应用场景和偏好使用最佳的开源和商业工具的能力。

Oracle Lakehouse模式的关键元素包括:

1、数据仓库:用于结构化,高价值的数据,直接从应用数据库集成过来,也可以存储其他数据技术的处理结果,以结构化为主,包括各种数据类型,属性图,地理,JSON等,同时可以直接融合访问数据湖中的数据。

2、数据湖:用于原始的、不易理解的、价值较低的数据或历史数据。通常用于加载到数据仓库之前的暂存,历史冷数据的存档和用于训练机器学习模型的综合数据的存储

3、管理的开源服务:支持用于数据存储和数据分析的主流开源技术,包括Apache Hadoop、Apache Spark和Redis等,通过组件也可以直接访问湖中数据。

4、数据集成:数据湖仓中的数据可以根据需要和使用场景在数据湖、数据仓库和开源分析环境之间移动和灵活处理,批量,实时或基于服务调用方式。

5、数据目录:维护所有可用数据的统一的、完整的视图,可定义业务视图,以便发现和管理。

如下图所示,Oracle提供了一系列云平台服务,支持数据湖仓的卓越实现,各组件、数据目录和数据湖之间的紧密集成,实现了针对对象存储的无缝查询,在OCI或客户的数据中心提供全面的数据和隐私保护(具体服务介绍请见本文尾部)。

Oracle湖仓一体解决方案不同之处在于:

·集成数据仓库和数据湖:能处理所有数据的融合分析任务,考虑数据存储的时候,可以根据数据类型,读写需求,整体成本,选择最合适的存储方式,而不是为了适应某种技术需要逐层处理和汇总加工。

·消除数据孤岛:数据可以根据需要在仓库和湖之间协同访问,无论是结构化,半结构化还是非结构化数据,都可以针对内容进行查询。也可以按需进行移动,加工和转换。

·支持流行的开源技术和商业工具:支持用户对于开源和商业工具技术路线的选择来访问所有数据。Oracle提供了丰富的SQL,支持统一对数据进行查询和处理,用户也可以通过开源的Hadoop相关组件,联合查询数据。

·适用场景的广泛性:支持多种数据源、数据格式和数据类型(结构化、半结构化和非结构化)。支持各种数据消费程序和工作负载,包括所有行业的大数据分析、SQL和BI、数据科学和机器学习。

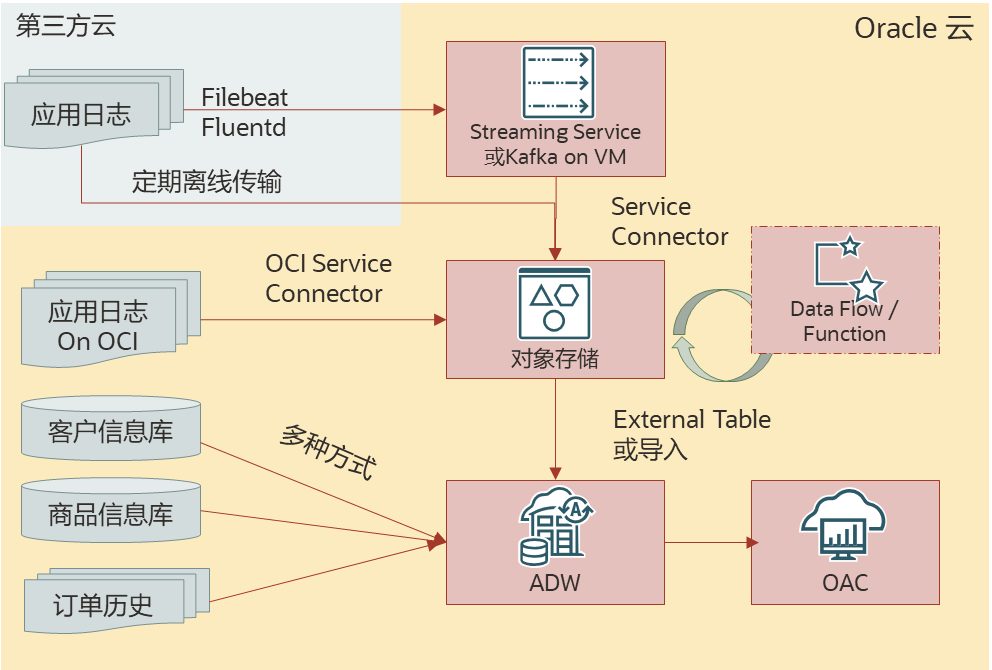

下面我们就以跨境电商的数据应用场景为例,介绍一下Oracle湖仓一体是如何实现数据融合分析探索的。其中涉及到的数据包括网站日志,订单历史数据,应用系统数据和第三方数据等。使用的场景是收集网站日志,分析网站指标和用户浏览行为,结合商品信息和历史订单,利用机器学习能力实现商品关联分析。

电商日志存储的信息比较多,尤其是用户访问网站的行为或网站统计指标的来源,因为日志中包括来访者IP地址,浏览器类型,访问时间,访问页面,上一个访问页面,会话ID等信息,有的自开发网站也会把应用访问或操作信息以JSON方式记录在日志中,虽然现在很多网站也采用埋点的方式来记录和分析用户的行为,但日志分析也有诸多优势,例如可以不改变现有网页,基于Oracle湖仓一体技术快速获取和启动分析。

针对网站日志,Oracle支持多种方式收集,针对应用部署在第三方云上,日志也在其中,可以通过开源的FileBeat/Fluented把日志收集到Oracle Streaming Service或kafka,Oracle提供了Service Connector可以直接把数据从Streaming Service存储到对象存储中,如果应用部署在Oracle云中,那么可以启动Oracle提供的部署在VM的Agent服务,通过配置Service Connector,也可以把日志数据直接收集,自动化存储到对象存储中,而ADW可以直接通过外部表方式使用OracleSQL查询这些日志数据,无需移动或预先转化和提取。

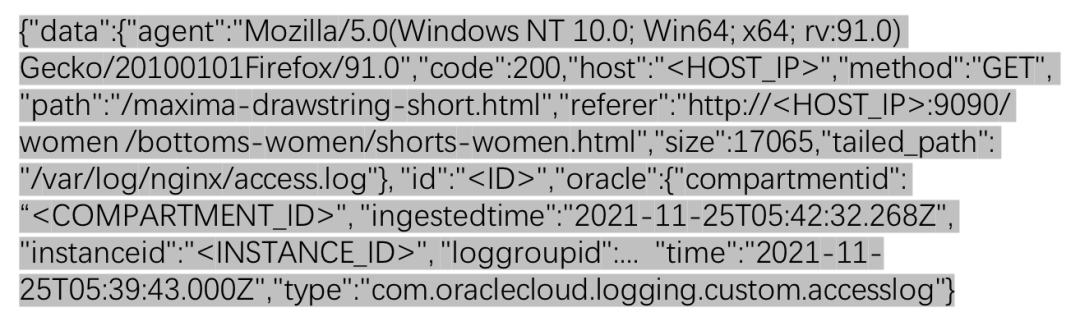

如下是基于Magento构建的示例电商网站,与Ngnix集成后生成的网站访问日志,通过Service Connector自动抽取以后的格式,其中某一条示例:

其中“data”后面的内容就是来自于Ngnix日志,包括客户端浏览器里类型,访问状态,访问者IP,访问方法,访问的页面URI,从哪个页面跳转过来,内容长度,日志文件来源等,Oracle ServiceConnector在抽取时会在每一条后面加上一些系统参数,例如时间,租户和实例信息等,获取的内容会定期以压缩文件gz的形式传输存储在配置的对象存储bucket中。

这种格式日志存储在对象存储中,可以通过Oracle Function编写代码处理,也可以通过Data Flow服务按需通过Spark脚本处理,或者通过OracleData Integration图形化界面处理,但如果只是进行一些统计查询,也可以通过ADW直接访问和查询日志数据,只是简单配置和映射,无需编写代码和移动数据。

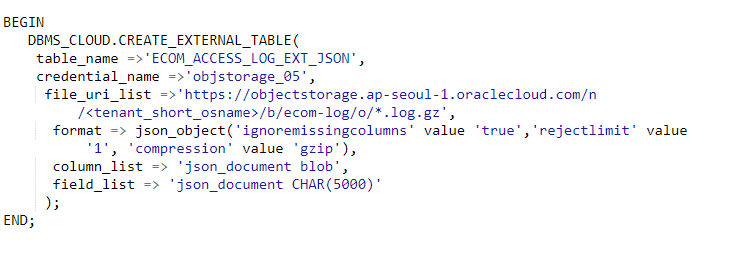

如下是ADW中通过配置,将特定bucket下收集的所有日志压缩文件映射成外部表ECOM_ACCESS_LOG_EXT_JSON,其中objstorage_05是事先配置的可访问bucket的凭证:

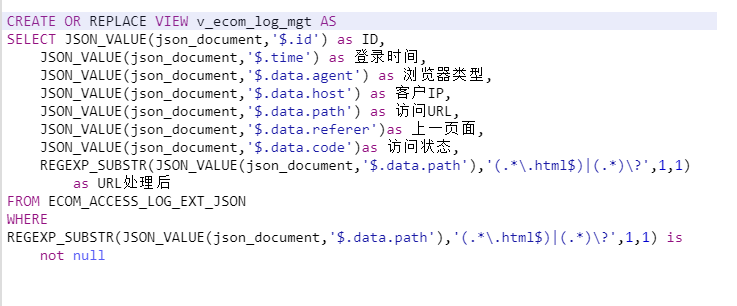

执行显示成功后,查询ECOM_ACCESS_LOG_EXT_JSON内容,可以看到表只有一个类型是BLOB的字段。可以利用ADW对JSON的支持,无需把JSON格式拆开,即可通过函数实现对JSON内部内容的提取,同时可以利用ADW对正则表达式的支持,过滤掉一部分网页上图片或其他文件的链接,只统计主页面,创建视图,具体如下:

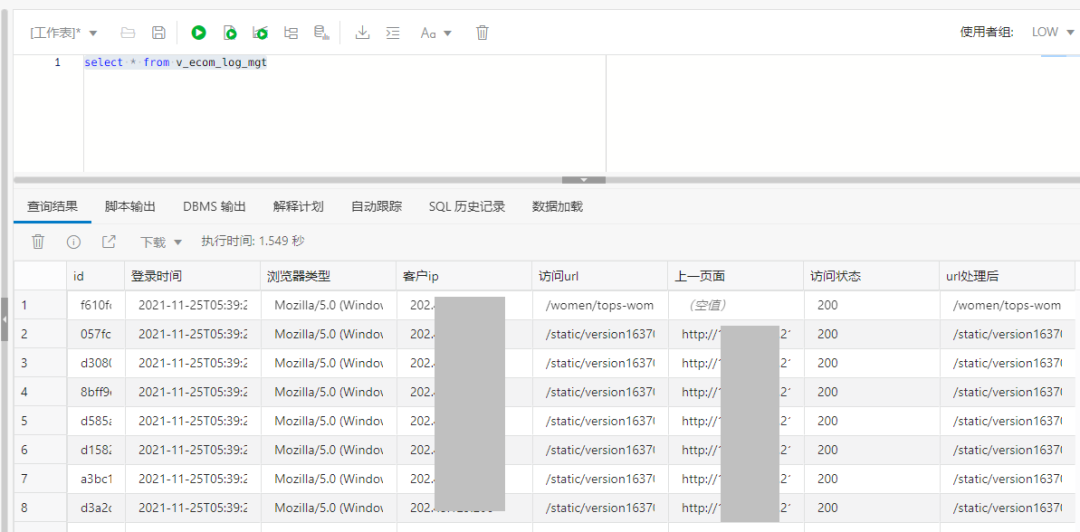

对视图v_ecom_log_mgt进行查询,可以看到如下结果:

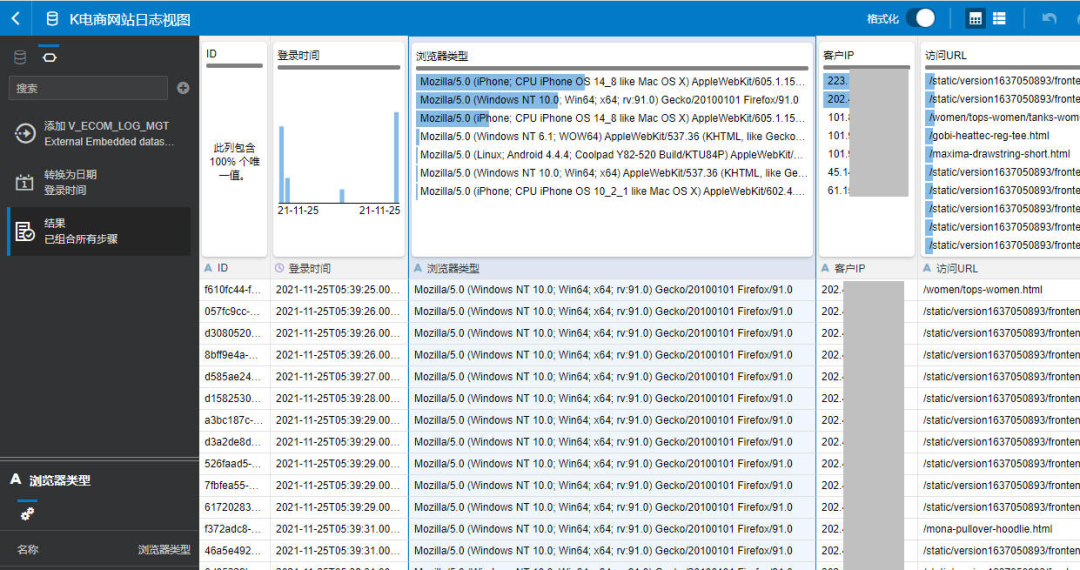

直接在Oracle分析云OAC中将视图v_ecom_log_mgt加入生成新的数据集,可以看到如下效果:

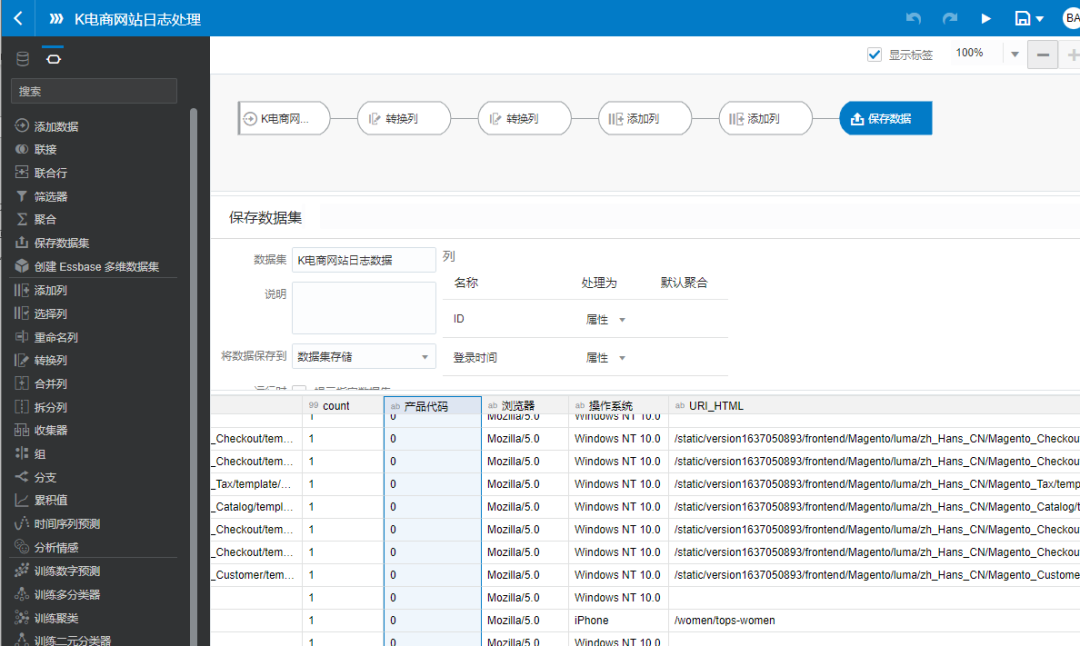

如果这些数据格式不满足业务人员分析需求,也可以通过OAC中的数据流对这个数据集进行加工,无需编码,生成新的数据集,例如可以提取URL中的商品代码,拆分出浏览器和操作系统信息等:

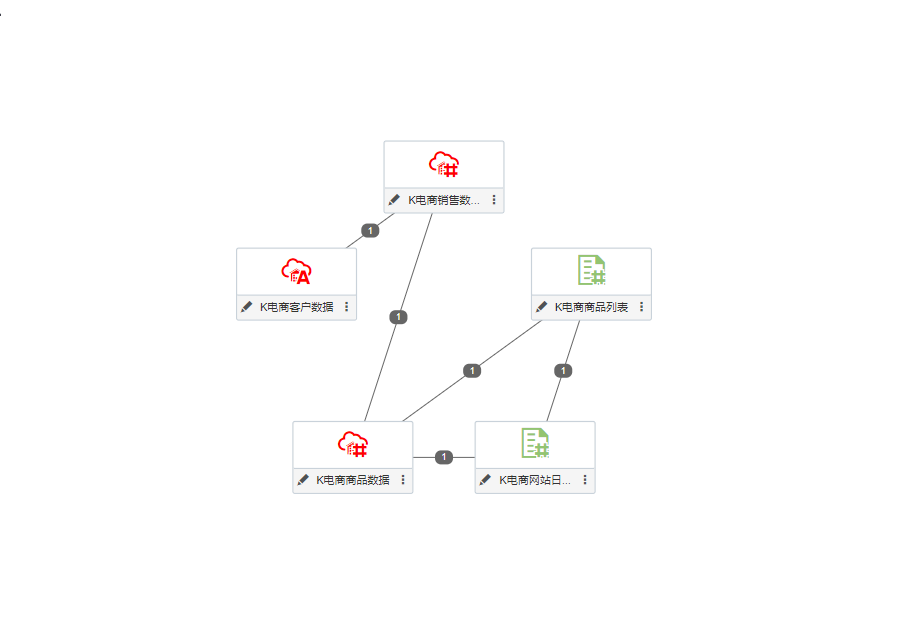

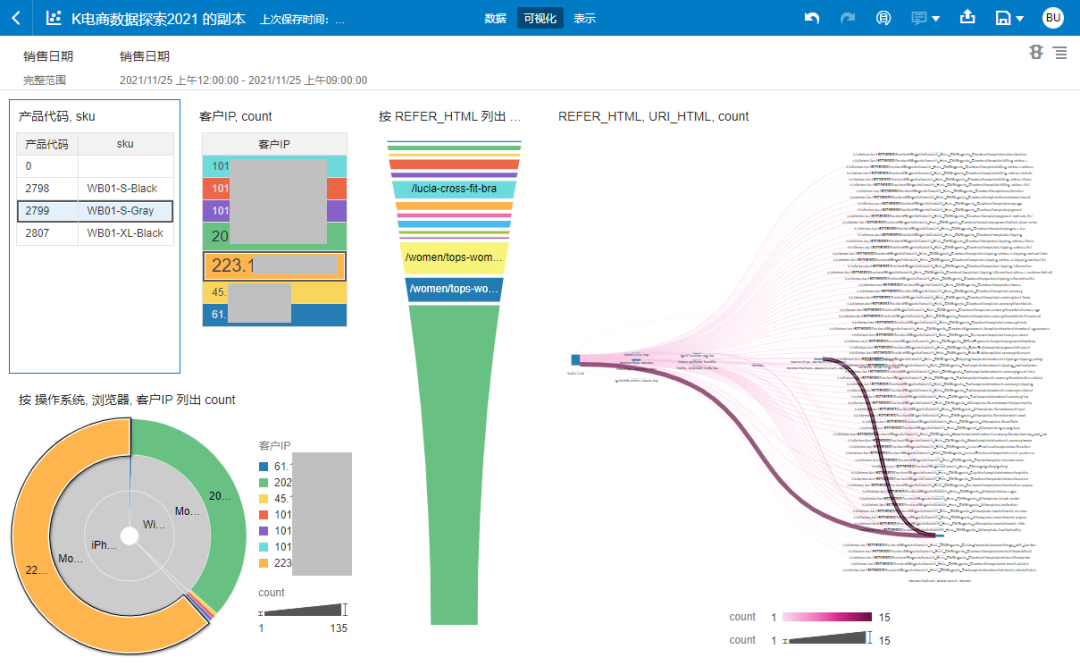

用生成的新的日志数据集创建数据分析项目,和商品数据集轻建模关联,简单拖曳,即可以快速形成数据分析图表,包括访问的客户端IP分布,操作系统浏览器分布,访问的动态商品ID和SKU,网页访问路径等,也可以针对某些客户或时间段灵活过滤,如图:

接下来我们可以针对用户浏览的商品SKU,结合历史购买记录,利用ADW的机器学习能力,进行商品关联分析,看看客户历史购买特定商品的同时购买可能性比较大的其他商品有哪些,这样就可以在用户浏览这些商品的时候,进行关联推荐。

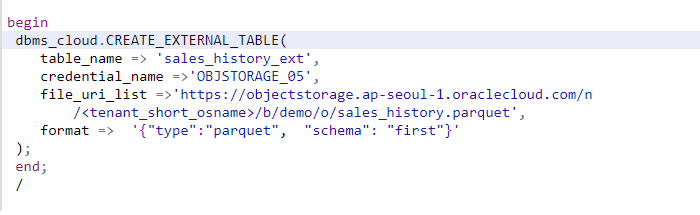

有些跨境电商企业已经构建了大数据集群,存储和处理产生的历史数据,为了节省成本,往往会把大数据产生的数据存储在对象存储中,以Parquet或者ORC格式,针对这些数据,可以以文件方式存储到对象存储上,ADW也可以无需移动,直接配置即可查询访问。

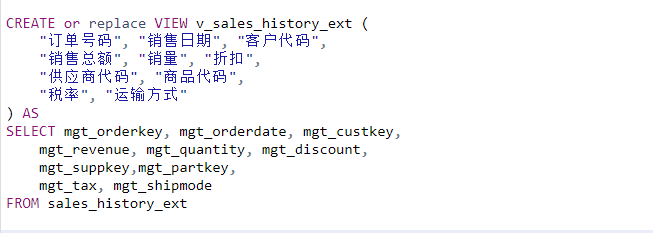

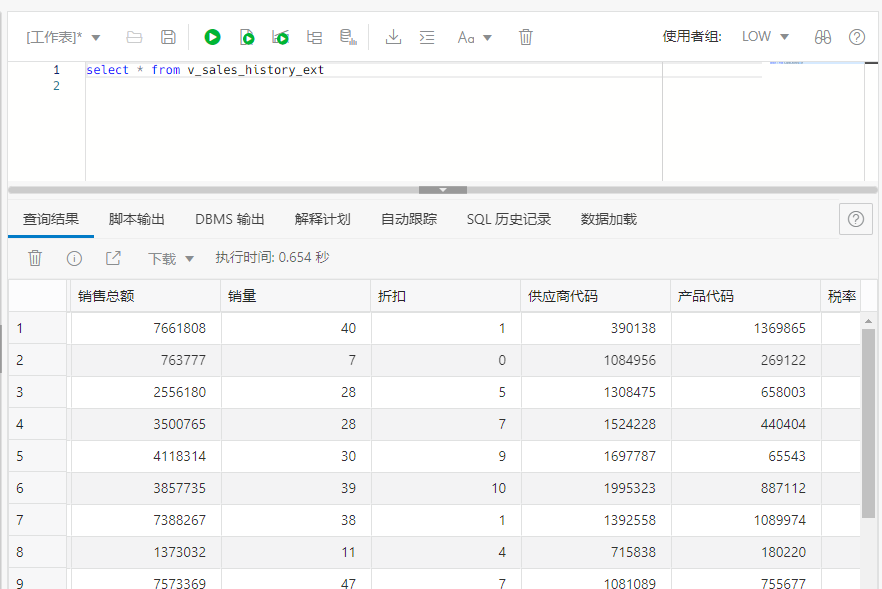

Parquet文件已经带有了数据格式,因此format中不用定义格式,ADW会自动读取并且进行数据格式映射,建立外部表sales_history_ext。为了业务人员分析方便,可以直接构建业务视图,把原始列名转化为具有业务语义的名称,这样可以直接作为数据集快速分析:

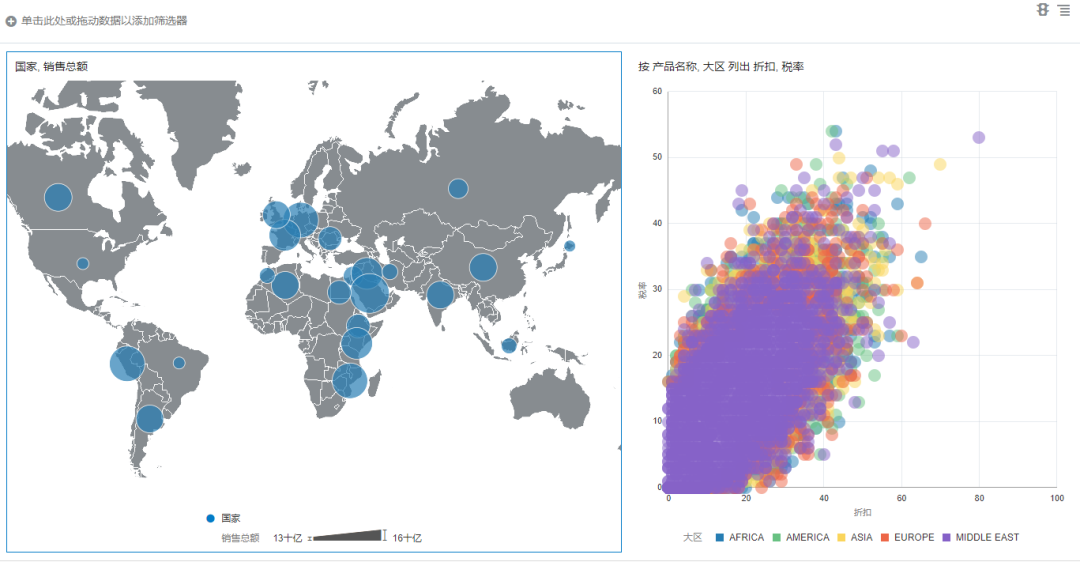

在OAC中通过拖曳形成分析图表,浏览商品购买地区分布和价格折扣,税率等分布,可以看到商品在欧洲,东非和西亚销售比较好。

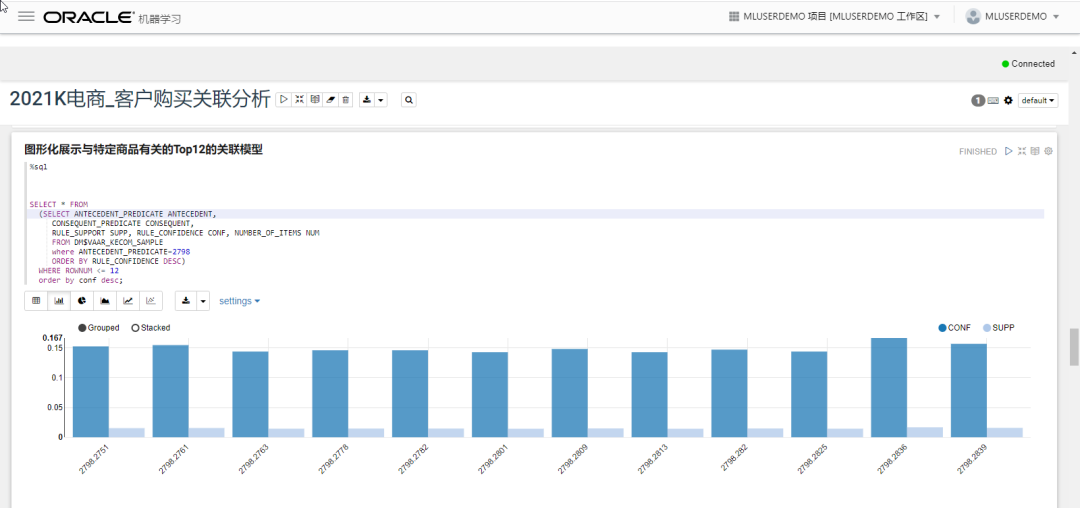

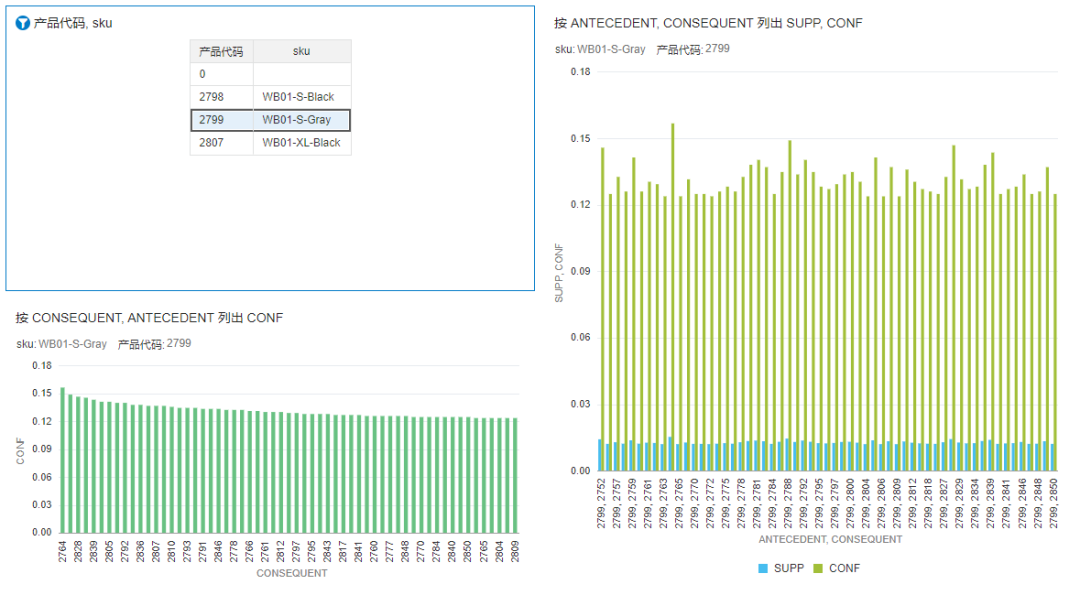

使用ADW提供的Machine Learning的Web界面,可以利用SQL实现机器学习建模和预测,我们使用销售历史数据,将订单和客户作为购买商品的分布键,对商品关联性进行智能分析,可以获得商品关联关系,即客户在购买商品A的同时,购买可能性比较大的商品有哪些。以前面查询的商品2798,2799和2807为例,可以在Machine Learning中通过机器学习获得关联度比较高的其他商品:

也可以在OAC中关联数据集,实现商品关联的动态过滤和联动分析:

第三方提供的导出数据,或者应用批量导出的数据,如果是以CSV方式,可以直接被ADW作为外部表使用,如果是JSON格式,和前面解析日志文件内容类似,ADW也能够完美支持,不需要预先处理拆分JSON的关键字和值,而是按照需求,可以直接使用SQL或者视图方式定义,提取出JSON整个字符串中的特定关键字取值。

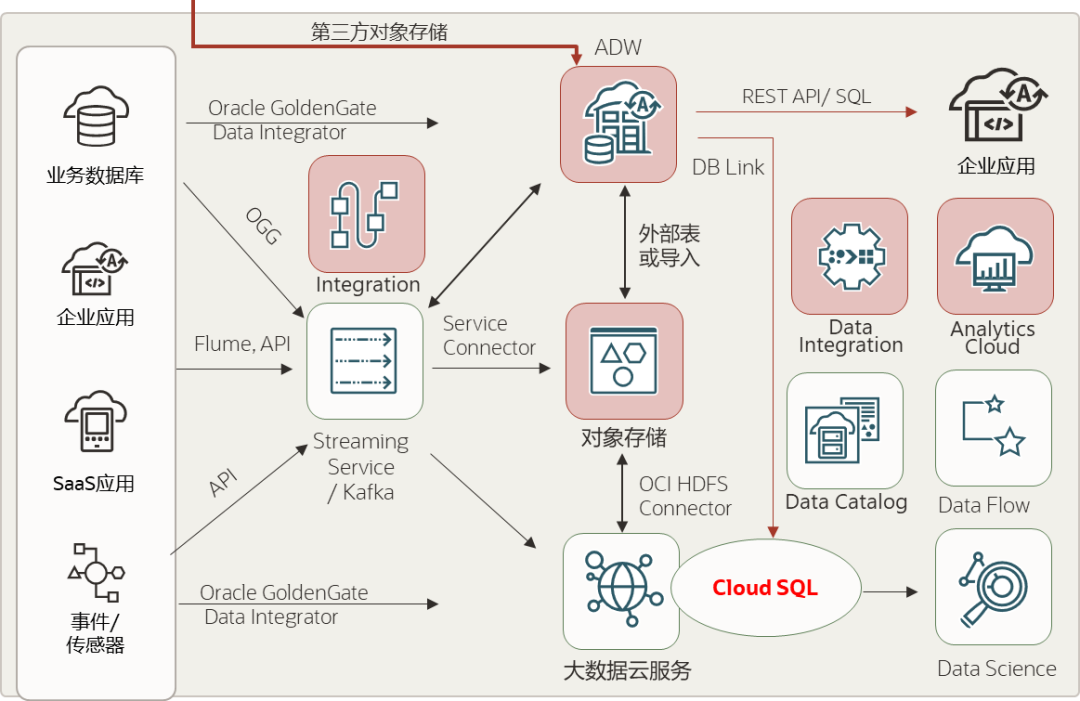

最后介绍一下Oracle云中湖仓一体解决方案相关的关键云服务:

·Oracle自治数据仓库云服务(ADW)提供了简单,快速,弹性的企业级数据仓库/数据集市能力,自动优化数据管理和处理交付,易于管理和使用,聚焦在数据本身和业务。

·Streaming Service支持实时数据流接收和订阅,与Kafka兼容,接收和发布实时数据流,例如事件,日志提取等,也可自建Kafka集群

·Big Data Service提供安全可靠,灵活扩展的Hadoop集群及相关组件,支持数据快速写入,简单查询,复杂计算多种场景。

·Cloud SQL支持通过SQL统一访问大数据云Hadoop,Hive,Kafka中的数据,支持结合ADW通过SQL融合分析跨平台数据

·通过HDFS Connector,可实现大数据云服务数据和对象存储之间的集成,包括把数据卸载到对象存储中,或者导入数据和通过Hive外部表方式直接访问对象存储中数据,也支持其他组件外部表访问,例如Presto。

·Analytics Cloud提供经典商务报表,敏捷可视化和机器学习能力,便于快速探索和数据洞察,转化数据价值

·Data Flow提供了Spark离线计算服务,按需启动停止和按使用计费。它提供日志管理和运行时环境来执行应用程序,消除了设置基础设施、集群配置、软件安装、存储和安全性的需要。

·Data Science提供了交互协同的机器学习环境,内置多种Python机器学习开发包,支持数据科学家构建、训练、部署和管理机器学习模型。数据科学家可以使用Oracle增强的Oracle加速数据科学(ADS)库进行自动化机器学习(AutoML)、模型评估和模型解释。

·Data Catalog支持作为单一协作环境来管理技术、业务和运营元数据。可以从各种可使用公共或私有IP地址访问的受支持数据源中获取技术元数据,可以组织、查找、访问、理解、丰富和激活此元数据。利用按需或基于计划的自动收集来确保数据目录始终具有最新信息。

·Data Integration是一项完全托管的无服务器云服务,提供图形化的Oracle数据流设计器,有助于简化复杂的数据提取、转换和加载过程。

TG客服:@SSjiejie — 官方频道:@SSwangluo

三生网络 © 2009-2023 超15年出海经验,跨境项目专家